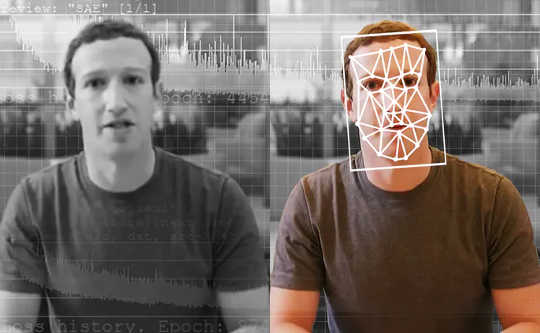

Детектори на основі штучного інтелекту - найкращі інструменти для виявлення підроблених відео, створених за допомогою штучного інтелекту. The Washington Post через Getty Images

Журналіст-розслідувач отримує відео від анонімного викривача. На ній видно, як кандидат у президенти визнав протиправну діяльність. Але чи справжнє це відео? Якщо так, то це була б величезна новина - совок на все життя - і могла б повністю розвернути майбутні вибори. Але журналістка запускає відео через спеціалізований інструмент, який каже їй, що відео не те, що здається. Насправді це "глибокий розбір, ”Відео, зроблене з використанням штучного інтелекту глибоке навчання.

Журналісти всього світу незабаром можуть скористатися подібним інструментом. За кілька років такий інструмент міг би навіть використовувати кожен, щоб викорінити підроблений вміст у своїх стрічках соціальних мереж.

As Дослідники які вивчали виявлення фальшивих фальшивок і розробляючи інструмент для журналістів, ми бачимо майбутнє цих інструментів. Однак вони не вирішать усіх наших проблем, і вони будуть лише однією частиною арсеналу в ширшій боротьбі з дезінформацією.

Проблема з фальшивими фальшивками

Більшість людей знає, що ти не можеш повірити усьому, що бачиш. За останні пару десятиліть кмітливі споживачі новин звикли бачити зображення, маніпульовані програмним забезпеченням для редагування фотографій. Однак відео - це вже інша історія. Голівудські режисери можуть витратити мільйони доларів на спецефекти, щоб створити реалістичну сцену. Але, використовуючи фальшиві фальшивки, аматори з кількома тисячами доларів комп’ютерної техніки та кількома тижнями, які можна витратити, можуть зробити щось майже так само вірним життю.

Глибокі фальшивки дозволяють залучити людей до кінофільмів, в яких вони ніколи не були - Подумайте, що Том Круз грає Залізну людину - що робить розважальні відео. На жаль, це також дає можливість творити порнографія без згоди зображених людей. Поки що саме ці люди, майже всі жінки, є найбільшими жертвами при зловживанні технологією глибоких підробок.

Глибокі фальшивки також можна використовувати для створення відеофільмів політичних лідерів, які говорять те, чого ніколи не говорили. Бельгійська соціалістична партія опублікувала неякісне недоступне, але все ще фальшиве відео Президент Трамп ображає Бельгію, яка отримала достатньо реакції, щоб показати потенційні ризики більш якісних фейків.

{vembed Y=poSd2CyDpyA}

Каліфорнійський університет, Хенрі Фарід, Берклі, пояснює, як робляться фальшиві фальшивки.

Можливо найстрашніший з усіх, їх можна використовувати для створення сумніви щодо змісту реальних відео, припустивши, що вони можуть бути фальшивими фальшивками.

Враховуючи ці ризики, було б надзвичайно цінним мати можливість виявити глибокі підробки та чітко їх позначити. Це гарантувало б, що фальшиві відео не обманюють громадськість, а реальні відео можуть бути отримані як справжні.

Виявлення підробок

Виявлення глибоких підробок як галузі досліджень було розпочато трохи пізніше Три роки тому. Ранні роботи були зосереджені на виявленні видимих проблем у відео, таких як фальшиві фальшивки, які не блимали. Однак з часом, підробки стали кращими імітуючи реальні відео, і їх стає важче помітити як для людей, так і для інструментів виявлення.

Існує дві основні категорії глибоко фальсифікованих досліджень. Перший включає дивлячись на поведінку людей у відео. Припустимо, у вас є багато відео про когось відомого, наприклад, про президента Обаму. Штучний інтелект може використовувати це відео, щоб вивчити його моделі, від жестів руками до пауз у мовленні. Тоді може стежте за фальшивою фальшивкою його і зауважте, де це не відповідає цим шаблонам. Цей підхід має перевагу можливо працювати, навіть якщо якість відео по суті ідеальна.

{vembed Y=gsv1OsCEad0}

Аарон Лоусон із SRI International описує один із підходів до виявлення фальшивих підробок.

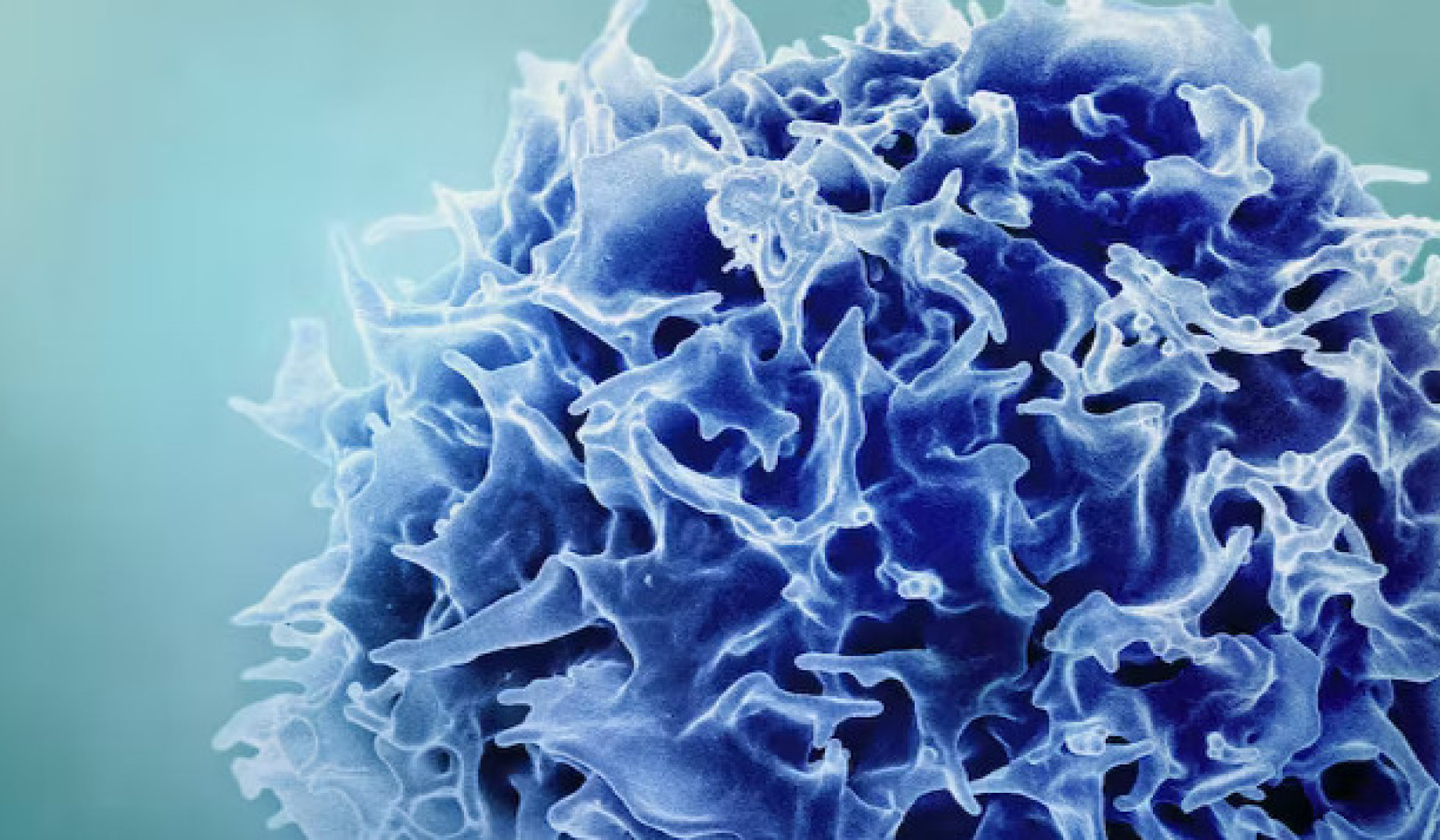

Інші дослідники, включаючи нашу команду, були зосереджені на Відмінності Що всі фальшиві фальшивки порівняно з реальними відео. Відео Deepfake часто створюються шляхом об'єднання індивідуально сформованих кадрів для формування відео. Враховуючи це, методи нашої команди витягують основні дані з граней в окремих кадрах відео, а потім відстежують їх через набори одночасних кадрів. Це дозволяє виявляти невідповідності в потоці інформації від одного кадру до іншого. Ми використовуємо подібний підхід і для нашої підробленої системи виявлення звуку.

Людям важко побачити ці тонкі деталі, але вони показують, наскільки глибокі фейки не зовсім точні ще ідеально. Такі детектори можуть працювати на будь-яку людину, а не лише на кількох світових лідерів. Врешті-решт, можливо, знадобляться обидва типи глибинних детекторів.

Останні системи виявлення дуже добре працюють на відео, спеціально зібраних для оцінки інструментів. На жаль, навіть найкращі моделі це роблять погано на відео, знайдених в Інтернеті. Покращення цих інструментів, щоб вони стали більш надійними та корисними, є ключовим наступним кроком.

Хто повинен використовувати детектори глибокої підробки?

В ідеалі, інструмент глибокої перевірки має бути доступний кожному. Однак ця технологія знаходиться на ранніх стадіях розвитку. Дослідники повинні вдосконалити інструменти та захистити їх від хакерів, перш ніж широко їх випускати.

У той же час, однак, інструменти для створення глибоких підробок доступні кожному, хто хоче обдурити громадськість. Сидіти збоку - не варіант. Для нашої команди правильним балансом була робота з журналістами, оскільки вони є першою лінією захисту від поширення дезінформації.

Перш ніж публікувати матеріали, журналістам потрібно перевірити інформацію. У них вже є випробувані методи, такі як перевірка з джерелами та отримання кількох осіб для перевірки ключових фактів. Тож, передаючи інструмент у руки, ми надаємо їм більше інформації, і ми знаємо, що вони не будуть покладатися лише на технологію, враховуючи, що вона може припуститися помилок.

Чи можуть детектори виграти гонку озброєнь?

Приємно бачити команди з Facebook та Microsoft інвестування в технології для розуміння та виявлення фальшивих фальшивок. Ця сфера потребує додаткових досліджень, щоб йти в ногу зі швидкістю прогресу в технологіях глибокої підробки.

Журналістам та платформам соціальних медіа також потрібно з’ясувати, як найкраще попередити людей про фальшиві фальшивки, коли їх виявлять. Дослідження показали, що люди пам’ятають брехню, але не факт, що це була брехня. Чи буде так само і для підроблених відео? Простого введення "Deepfake" у заголовок може бути недостатньо для протидії деяким видам дезінформації.

Deepfakes тут залишаються. Управління дезінформацією та захист громадськості буде ще складнішим, ніж будь -коли, оскільки штучний інтелект стає все більш потужним. Ми є частиною зростаючої дослідницької спільноти, яка бере на себе цю загрозу, і виявлення - це лише перший крок.![]()

Про авторів

Джон Сохраварді, докторант комп'ютерних та інформаційних наук, Рочестерський технологічний інститут та Метью Райт, професор комп'ютерної безпеки, Рочестерський технологічний інститут

Ця стаття перевидана з Бесіда за ліцензією Creative Commons. Читати оригінал стаття.