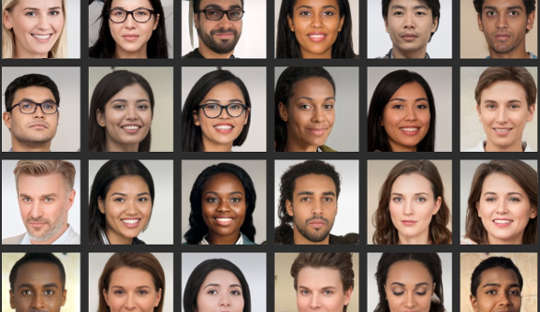

Навіть якщо ви думаєте, що добре аналізуєте обличчя, Дослідження показують, багато людей не можуть достовірно відрізнити фотографії справжніх облич від зображень, згенерованих комп’ютером. Це особливо проблематично зараз, коли комп’ютерні системи можуть створювати реалістичні фотографії людей, яких не існує.

Нещодавно фальшивий профіль LinkedIn із зображенням профілю, створеним комп’ютером, потрапив у новини, тому що він успішно зв'язувався з офіційними особами США та іншими впливовими особами на мережевій платформі, наприклад. Експерти з контррозвідки навіть кажуть, що шпигуни регулярно створюють фантомні профілі з такими зображеннями, щоб через соціальні медіа на чужих цілях.

Ці глибокі фейки стають широко поширеними в повсякденній культурі, а це означає, що люди повинні більше знати про те, як їх використовують у маркетингу, рекламі та соціальних мережах. Зображення також використовуються для зловмисних цілей, таких як політична пропаганда, шпигунство та інформаційна війна.

Для їх створення використовується така звана глибока нейронна мережа, комп’ютерна система, яка імітує спосіб навчання мозку. Це «тренується» шляхом показу все більших наборів даних реальних облич.

Насправді дві глибокі нейронні мережі протистоять одна одній, змагаючись за створення найбільш реалістичних зображень. У результаті кінцеві продукти отримують зображення GAN, де GAN означає Generative Adversarial Networks. Процес генерує нові зображення, які статистично не відрізняються від навчальних зображень.

У нашому дослідженні, опублікованому в iScience, ми показали, що нездатність відрізнити ці штучні обличчя від справжніх має наслідки для нашої поведінки в Інтернеті. Наше дослідження показує, що підроблені зображення можуть підірвати нашу довіру до інших і кардинально змінити спосіб спілкування в Інтернеті.

Ми з колегами виявили, що люди сприймають обличчя GAN навіть більш реальними, ніж справжні фотографії облич справжніх людей. Хоча поки що незрозуміло, чому це так, ця знахідка зрозуміла висвітлити останні досягнення в технології використовується для створення штучних зображень.

Крім того, ми знайшли цікавий зв’язок із привабливістю: обличчя, які були оцінені як менш привабливі, також були оцінені як більш реальні. Менш привабливі обличчя можна вважати більш типовими типове обличчя може бути використане як посилання за яким оцінюються всі обличчя. Таким чином, ці обличчя GAN виглядатимуть більш реальними, оскільки вони більше схожі на ментальні шаблони, які люди створили з повсякденного життя.

Але сприйняття цих штучних облич як справжніх також може мати наслідки для загального рівня довіри, яку ми поширюємо на коло незнайомих людей — концепція, відома як «соціальна довіра».

Ми часто читаємо занадто багато в обличчях, які бачимо, і перше враження, яке ми формуємо, керує нашими соціальними взаємодіями. У другому експерименті, який був частиною нашого останнього дослідження, ми побачили, що люди частіше довіряють інформації, переданій особами, які вони раніше вважали справжніми, навіть якщо вони були створені штучно.

Не дивно, що люди більше довіряють обличчям, які вважають справжніми. Але ми виявили, що довіра була підірвана, коли людей повідомили про потенційну присутність штучних облич у онлайн-взаємодіях. Тоді вони продемонстрували нижчий рівень довіри, незалежно від того, справжні були обличчя чи ні.

Цей результат можна вважати корисним у певному сенсі, тому що він зробив людей більш підозрілими в середовищі, де можуть працювати фальшиві користувачі. З іншої точки зору, однак, це може поступово руйнувати саму природу нашого спілкування.

Взагалі ми схильні оперувати типове припущення, що інші люди в основному правдиві та заслуговують довіри. Зростання кількості фальшивих профілів та іншого штучного онлайн-контенту ставить питання про те, наскільки їх присутність і наші знання про них можуть змінити цей стан «правдивого замовчування», зрештою підриваючи соціальну довіру.

Зміна наших параметрів за замовчуванням

Перехід до світу, де те, що є реальним, неможливо відрізнити від того, що не є, може також змінити культурний ландшафт із переважно правдивого на штучний і оманливий.

Якщо ми регулярно сумніваємося в правдивості того, що ми відчуваємо в Інтернеті, це може вимагати від нас перерозподілу наших розумових зусиль з обробки самих повідомлень на обробку особистості месенджера. Іншими словами, широке використання дуже реалістичного, але штучного онлайн-контенту може вимагати від нас інших думок – у спосіб, на який ми не очікували.

У психології ми використовуємо термін «моніторинг реальності» для того, як ми правильно визначаємо, що надходить із зовнішнього світу чи з нашого мозку. Розвиток технологій, які можуть створювати підроблені, але дуже реалістичні обличчя, зображення та відеодзвінки, означає, що моніторинг реальності має базуватися на інформації, відмінній від наших власних суджень. Це також закликає до ширшого обговорення того, чи може людство все ще дозволити собі замовчувати правду.

Людям важливо бути більш критичними, оцінюючи цифрові обличчя. Це може включати використання зворотного пошуку зображень, щоб перевірити, чи фотографії справжні, бути обережним щодо профілів у соціальних мережах з невеликою кількістю особистої інформації або великою кількістю підписників, а також усвідомлювати потенціал технології deepfake, яка може використовуватися в мерзенних цілях.

Наступним рубежем у цій галузі мають стати вдосконалені алгоритми виявлення підроблених цифрових облич. Потім їх можна вставити в соціальні медіа-платформи, щоб допомогти нам відрізнити справжні від фальшивих, коли йдеться про обличчя нових зв’язків.

про автора

Манос Цакіріс, професор психології, директор Центру політики почуттів, Королівський Холлоуей Лондонського університету

Ця стаття перевидана з Бесіда за ліцензією Creative Commons. Читати оригінал статті.