Якщо ви отримуєте свої новини з соціальних мереж, як більшість американців, ви стикаєтесь із щоденною дозою обману, чуток, теорій змови та оманливих новин. Коли все це змішується з надійною інформацією з чесних джерел, правду може бути дуже важко розпізнати.

Насправді, аналіз даних моєї дослідницької групи з Колумбійського університету Аварійний слух трекер припускає, що це дезінформація так само ймовірно стане вірусною як достовірна інформація.

Багато хто запитує, чи не є це натиском цифрової дезінформації вплинули на результат виборів у США 2016 року. Правда в тому, що ми не знаємо, хоча є підстави вважати, що це цілком можливо, базуючись на минулий аналіз та рахунки з інших країн. Кожна дезінформація сприяє формуванню наших думок. Загалом, шкода може бути дуже реальною.

Як дослідник поширення дезінформації через соціальні мережі, я знаю, що обмеження можливості фальсифікаторів новин продавати рекламу, як нещодавно оголосив Google та Facebook, є кроком у правильному напрямку. Але це не дозволить приборкати зловживання, спричинені політичними мотивами.

Експлуатування соціальних мереж

Близько 10 років тому ми з колегами керували програмою експеримент в якому ми дізналися, що 72 відсотки студентів коледжів довіряють посиланням, які, мабуть, походять від друзів - навіть до того, що вводять особисту інформацію для входу на фішингові сайти. Ця широко поширена вразливість припускає іншу форму зловмисних маніпуляцій: люди також можуть повірити в дезінформацію, яку вони отримують, натискаючи посилання із соціального контакту.

Щоб дослідити цю ідею, я створив підроблена веб-сторінка із випадковими, створеними комп’ютером новинами про плітки - такі речі, як „Celebrity X потрапив у ліжко зі Celebrity Y!” Відвідувачі сайту, які шукали ім’я, запускали сценарій для автоматичного вигадування історії про людину. Я включив на сайт застереження, сказавши, що сайт містить безглуздий текст та вигадані "факти". Я також розмістив оголошення на сторінці. Наприкінці місяця я отримав поштою чек із прибутком від реклами. Це був мій доказ: підроблені новини могли заробляти гроші, забруднюючи Інтернет брехнею.

На жаль, я не був єдиним, хто мав цю ідею. Десять років потому у нас є індустрія фейкових новин та цифрова дезінформація. Сайти Clickbait виробляють підробки, щоб заробляти гроші на рекламі, тоді як так звані гіперпартійні сайти публікують і поширюють чутки та теорії змови з метою впливу на громадську думку.

Ця галузь підкріплюється тим, як легко її створювати соціальні боти, підроблені акаунти, керовані програмним забезпеченням, які схожі на реальних людей і, отже, можуть мати реальний вплив. Дослідження в моєму lab розкрив багато прикладів фальшивих масових кампаній, які також називають політичний астротурфінг.

У відповідь ми розробили BotOrNot інструмент для виявлення соціальних ботів. Це не ідеально, але досить точний розкрити кампанії переконання у рухах за Brexit та Antivax. Використовуючи BotOrNot, наші колеги виявили, що a велика порція онлайн-балаканини про вибори 2016 року створили боти.

Створення інформаційних бульбашок

Ми, люди, вразливі до маніпуляцій за допомогою цифрової дезінформації завдяки складному набору соціальних, когнітивних, економічних та алгоритмічних упереджень. Деякі з них еволюціонували з поважних причин: довіра сигналам наших соціальних кіл та відкидання інформації, яка суперечить нашому досвіду, добре нам послужили, коли наш вид пристосувався уникати хижаків. Але в сьогоднішніх мережах, що скорочуються в Інтернеті, зв’язок із соціальною мережею з теоретиком змови з іншого боку планети не допомагає донести мої думки.

Копіювання наших друзів і відмова від тих, хто має різні думки, дають нам ехокамери поляризований що дослідники можуть з високою точністю сказати, чи є ви ліберальний або консервативний просто подивившись на своїх друзів. Структура мережі така щільний що будь-яка дезінформація поширюється майже миттєво всередині однієї групи і настільки відокремлена, що не надходить до іншої.

Всередині нашої бульбашки ми вибірково піддаємося інформації, узгодженої з нашими переконаннями. Це ідеальний сценарій для максимізації взаємодії, але згубний для розвитку здорового скептицизму. Підтвердження упередження змушує нас ділитися заголовком навіть не читаючи Стаття.

Наша лабораторія отримала особистий урок з цього, коли наш власний дослідницький проект став темою жорстока кампанія дезінформації напередодні проміжних виборів у США 2014 року. Коли ми досліджували, що відбувається, ми виявили фейкові новини про те, що наші дослідження переважно передаються користувачами Twitter у межах однієї партійної ехо-камери, великої та однорідної спільноти політично активних користувачів. Ці люди швидко ретвітили і не пропускали розвінчання інформації.

Вірусна неминучість

Наше дослідження показує, що з огляду на структуру наших соціальних мереж та нашу обмежену увагу, це так неминучий це хтось меми буде вірусною, незалежно від їх якості. Навіть якщо люди схильні обмінюватися інформацією вищої якості, мережа в цілому не ефективно розрізняти надійну та сфабриковану інформацію. Це допомагає пояснити всі вірусні містифікації, які ми спостерігаємо в дикій природі.

Команда економіка уваги дбає про решту: якщо ми звернемо увагу на певну тему, буде видано більше інформації по цій темі. Вигадувати інформацію та передавати її як факт дешевше, ніж повідомляти про справжню істину. І вигадки можуть бути адаптовані до кожної групи: консерватори читають, що папа підтримував Трампа, ліберали - що він підтримує Клінтон. Він не зробив ні того, ні іншого.

Поглянув на алгоритми

Оскільки ми не можемо звертати увагу на всі публікації в наших стрічках, алгоритми визначають, що ми бачимо, а що ні. Алгоритми, що використовуються сьогодні платформами соціальних медіа, розроблені для того, щоб визначити пріоритет залучуючих дописів - тих, на які ми, швидше за все, натискаємо, реагуємо на них і ділимось ними. Але нещодавній аналіз виявив, що навмисно оманливі сторінки отримали принаймні стільки ж обміну в Інтернеті і реакція як справжня новина.

Цей алгоритмічний ухил до залучення до істини підсилює наші соціальні та когнітивні упередження. Як наслідок, коли ми переходимо за посиланнями, розміщеними в соціальних мережах, ми, як правило, відвідуємо менший, більш однорідний безліч джерел, ніж коли ми проводимо пошук і відвідуємо найкращі результати.

Існуючі дослідження показують, що перебування в ехокамері може змусити людей довірливіший про прийняття неперевірених чуток. Але нам потрібно знати набагато більше про те, як різні люди реагують на одну містифікацію: одні поділяються нею одразу, а інші перевіряють факти спочатку.

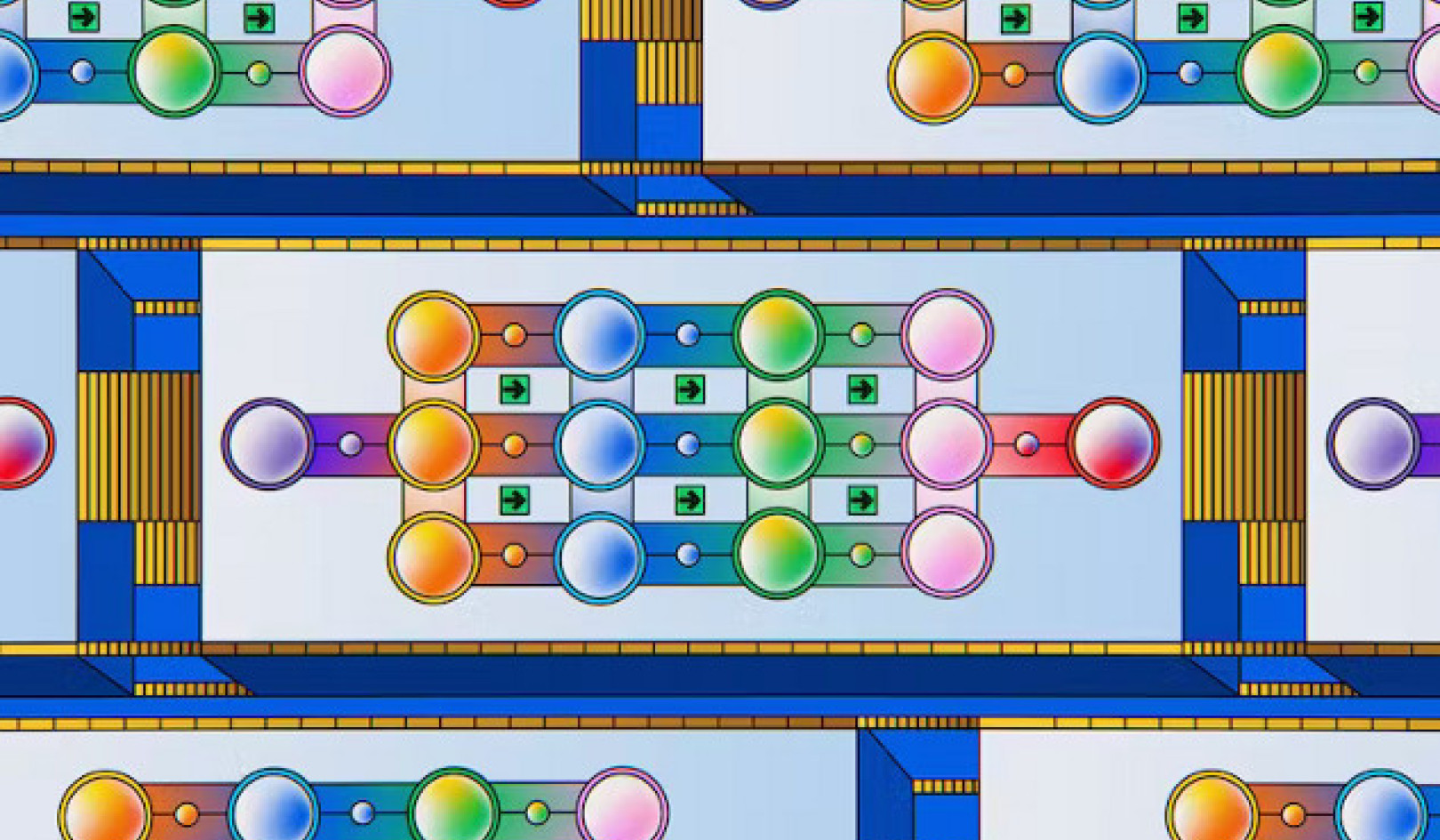

Ми моделювання соціальної мережі вивчити цю конкуренцію між обміном та перевіркою фактів. Ми сподіваємось допомогти розплутати суперечливі докази щодо коли перевірка фактів допомагає зупинити обман від розповсюдження та коли це не відбувається. Наші попередні результати дозволяють припустити, що чим більше відокремлена спільнота віруючих на обман, тим довше вижиття обману. Знову ж таки, мова йде не лише про саму обманку, а й про мережу.

Багато людей намагаються це зрозуміти що робити з усім цим. За останніми даними Марка Цукерберга оголошення, Команди Facebook тестують потенційні варіанти. І група студентів коледжу запропонувала спосіб просто позначте спільні посилання як "перевірено" чи ні.

Деякі рішення залишаються недосяжними, принаймні на даний момент. Наприклад, ми ще не можемо навчити систем штучного інтелекту, як це робити розрізнення між правдою та брехнею. Але ми можемо сказати алгоритмам ранжування надавати вищий пріоритет більш надійним джерелам.

Вивчення поширення фейкових новин

Ми можемо зробити нашу боротьбу з фальшивими новинами більш ефективною, якщо краще зрозуміти, як поширюється погана інформація. Якщо, наприклад, боти несуть відповідальність за багато брехні, ми можемо зосередити увагу на їх виявленні. Якщо ж проблема полягає в ехокамерах, можливо, ми могли б розробити системи рекомендацій, які не виключають різних поглядів.

З цією метою наша лабораторія будує платформу під назвою Підступна відстежувати та візуалізувати поширення неперевірених заяв та відповідну перевірку фактів у соціальних мережах. Це дасть нам реальні дані, за допомогою яких ми зможемо інформувати наші змодельовані соціальні мережі. Тоді ми зможемо перевірити можливі підходи до боротьби з фальшивими новинами.

Також містифікація може показати людям, наскільки легко їхніми думками маніпулювати інформацією в Інтернеті - і навіть наскільки ймовірно, що деякі з нас діляться брехнею в Інтернеті. Hoaxy приєднається до набору інструментів у нашому Обсерваторія соціальних медіа, що дозволяє кожному побачити, як меми поширюються у Twitter. Пов’язання подібних інструментів з людськими перевіряючими факти та платформами соціальних медіа може спростити мінімізацію дублювання зусиль та підтримка один одного.

Обов’язково потрібно вкладати ресурси у вивчення цього явища. Нам потрібні всі руки на палубі: це повинні зробити комп’ютерні вчені, соціологи, економісти, журналісти та промислові партнери працювати разом твердо протистояти поширенню дезінформації.

![]()

про автора

Філіппо Менцер, професор комп'ютерних наук та інформатики; Директор Центру комплексних мереж та системних досліджень, Університет штату Індіана, Блумінгтон

Ця стаття була спочатку опублікована на Бесіда. Читати оригінал статті.

Схожі книги:

at InnerSelf Market і Amazon